恭喜恭喜!🎉🎉🎉

“国考成功”这四个字背后,一定凝聚了你无数个日夜的辛勤汗水、坚持不懈的努力和沉着冷静的智慧,这份成功,是你应得的荣誉!

你即将踏上人生的新征程,开启一段全新的职业生涯,这无疑是激动人心的时刻,但同时也可能伴随着一些新的期待和挑战,为你梳理一下接下来你需要做的事情,希望能帮助你平稳过渡,顺利开启“打工人”的新篇章。

第一步:确认信息,保持冷静

- 核实信息:登录国家公务员局官网,仔细核对你的报考职位、面试通知、资格复审要求等所有官方信息,确保没有遗漏任何细节。

- 庆祝成功:给自己一个拥抱!可以好好吃一顿大餐,和亲朋好友分享你的喜悦,这是你努力换来的,值得好好庆祝!

第二步:全力以赴,准备面试

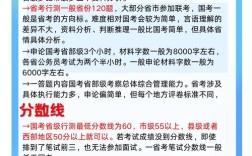

笔试只是第一关,面试才是决定最终成败的关键,国考面试竞争激烈,绝不能掉以轻心。

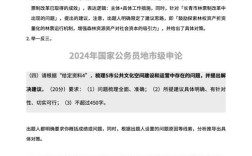

- 了解面试形式:国考面试通常采用结构化面试或无领导小组讨论,你需要立刻了解你报考的部门和岗位具体采用哪种形式,并有针对性地准备。

- 系统学习理论:学习面试的基本理论、评分标准、答题思路(如综合分析、应急应变、组织管理、人际关系、情景模拟等)。

- 大量开口练习:

- 对着镜子练:观察自己的仪容仪表、表情、肢体语言。

- 录音录像:回听自己的回答,检查语言流畅度、逻辑性和语速。

- 找人模拟:找家人、朋友或考友进行对练,模拟真实考场氛围,克服紧张情绪。

- 关注时事热点:多看新闻联播、人民日报评论员文章、学习强国等,积累时政素材,让自己的回答有深度、有高度。

- 了解报考单位:深入研究你所报考的部门是做什么的,其核心职能、工作重点、行业动态是什么,在面试中如果能结合岗位特点来回答,会是非常大的加分项。

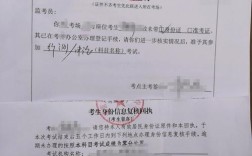

第三步:准备材料,通过政审

如果面试顺利通过,接下来就是政审环节,你需要提前准备好相关材料。

- 个人自传/个人总结:按要求撰写一份详细的个人经历、思想汇报等。

- 无犯罪记录证明:通常需要到户籍地或常住地的派出所开具。

- 毕业证、学位证原件及复印件:应届生可能需要提供《就业推荐表》。

- 档案材料:确认你的档案所在地,并按照单位要求调取或提供相关证明。

- 其他证明:如奖励证书、资格证书等,按需准备。

注意:政审不仅审查你本人,还会审查你的直系亲属,确保所有家庭成员的政治历史清白。

第四步:心态调整,迎接新生活

无论最终结果如何,这段经历都是一笔宝贵的财富。

- 保持谦虚:成功上岸只是新的开始,进入单位后,你是新人,要多看、多听、多学、少说,虚心向领导和老同事请教,尽快熟悉工作流程。

- 角色转换:从学生思维或社会考生思维,转变为“公务员”思维,要树立为人民服务的意识,有责任感和担当精神。

- 持续学习:体制内的工作需要不断学习新的政策法规、业务知识,保持学习的热情和能力,才能不断进步。

- 平衡生活:工作很重要,但健康和家庭同样重要,找到工作与生活的平衡点,保持积极乐观的心态。

也是最重要的:

这只是你人生众多挑战中的一个,你已经证明了自己的实力,无论未来道路如何,这份拼搏和坚持的精神将是你最宝贵的财富。

再次祝贺你!祝你面试顺利,马到成功,在新的岗位上发光发热,前程似锦!加油!✨